ChatGPT의 업그레이드 버전인 GPT-4, 기능부터 GPT3.5와의 차이점까지 이해하기 쉽게 소개해드리겠습니다.

안녕하세요 Allan입니다.

3/15일자로 ChatGPT의 업그레이드 버전인 GPT-4가 출시되었습니다.

Visual ChatGPT 출시되고 연달아 GPT-4가 출시되었네요.

이번 포스팅에서는 GPT-4의 기능 및 ChatGPT와의 차이점 그리고 이용방법에 대해서도 알아보도록 하겠습니다.

Ⅰ. GPT-4란??

OpenAI 공식홈페이지에 나온 GPT-4에 대한 설명은 다음과 같습니다.

We’ve created GPT-4, the latest milestone in OpenAI’s effort in scaling up deep learning.

GPT-4 is a large multimodal model (accepting image and text inputs, emitting text outputs) that,

while less capable than humans in many real-world scenarios,

exhibits human-level performance on various professional and academic benchmarks.

해석해 보자면, 다음과 같습니다.

딥 러닝을 확장하기 위한 OpenAI의 노력의 최신 이정표인 GPT-4를 만들었습니다.

GPT-4는 대규모 멀티모달 모델(이미지와 텍스트 입력을 받아들이고 텍스트 출력을 내보내는)입니다.

많은 실제 시나리오에서 인간보다 능력이 떨어지지만,

다양한 전문 및 학술 벤치마크에서 인간 수준의 성능을 보여줍니다.

두 가지의 큰 특징이 보입니다.

1. 대규모 멀티모달 모델 : 기존 ChatGPT와 달리 이미지의 입력도 받을 수 있습니다.

2. 전문적인 분야에서의 성능을 엄청나게 높였다고 합니다.

예를 들면, ChatGPT의 경우에는 모의변호사 시험에서 시험응시자의 하위 10% 정도의 수준의 점수를 받았다면

GPT-4는 상위 10% 정도의 점수를 받을 수 있다고 합니다.

Ⅱ. GPT-4의 기능/ChatGPT와 비교

OpenAI 공식문서에서 말하는 GPT-4와 ChatGPT의 기능적인 차이점을 정리해 보면 다음과 같습니다.

- 일상적인 대화에서 GPT3.5(ChatGPT)와 GPT-4의 차이는 미묘할 수 있습니다.

- 복잡한 작업이나, 전문성, 창의력, 추론능력이 요구되는 작업에서 GPT-4의 성능이 훨씬 뛰어납니다.

- GPT-4는 텍스트 및 이미지 프롬프트를 입력받을 수 있습니다. (멀티모달)

- 조종성이 뛰어납니다.

- 한번에 처리할 수 있는 단어의 양이 8배 증가했습니다. (3000개 ~ 25000개)

- 여전히 완전히 신뢰할 수는 없습니다. (하지만 GPT3.5보다 개선되었다고 합니다.)

- 유해한 답변을 하는 경향을 줄였습니다.

GPT-3.5와 같이 2021년까지의 정보를 반영하고 있다고 하고

몇 개의 매개변수를 가지고 있는지는 공개되지 않았습니다.

ChatGPT의 가장 큰 문제점이라고 지적되던 환각 문제가 어느 정도 해결된 것을 볼 수 있습니다.

환각 문제란 ChatGPT가 없는 말을 지어내거나, 없는 사실을 끌어다가 설명해 주는 문제들을 말합니다.

하지만 아직도 완전히 신뢰할 수는 없다고 하니 GPT-4의 응답을 너무 과신하면 안될 것 같습니다.

개인적으로 큰 변화라고 생각되는 부분인 2번, 3번에 대해서

함께 알아보도록 하겠습니다.

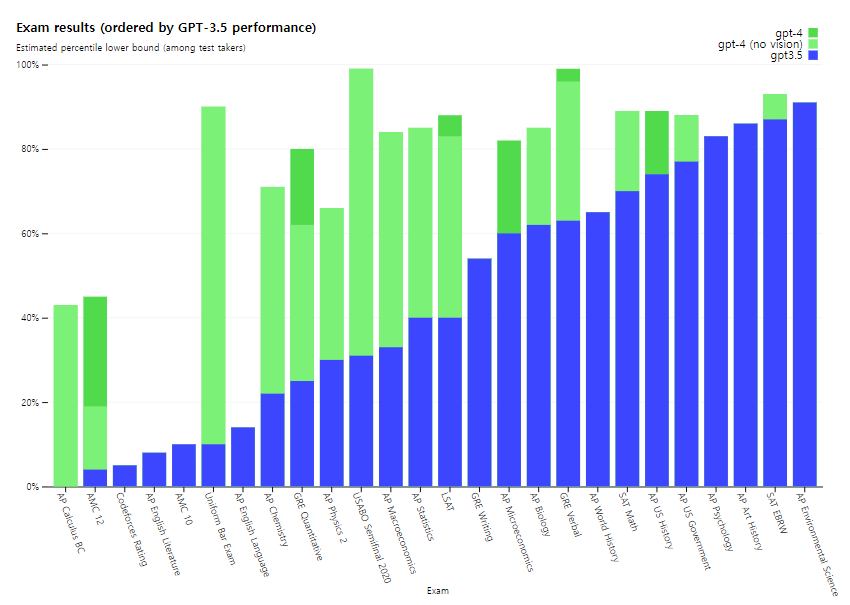

1. 복잡한 작업이나, 전문성, 창의력, 추론능력이 요구 되는 분야에서의 GPT-4의 성능

OpenAI에서 제시한 예시를 보여드리도록 하겠습니다.

파란색 차트가 GPT 3.5의 점수이고 초록색이 GPT-4의 점수입니다.

전문성이 필요한 거의 모든 테스트에서 GPT-가 GPT-3.5에 비해 높은 점수를 받았다는 것을 볼 수 있습니다.

한 번에 더 많은 단어를 처리할 수 있게 되었다는 부분도

이러한 전문성이 필요하거나 복잡한 작업이 요구되는 분야에서 더 큰 영향력을 발휘할 것으로 생각됩니다.

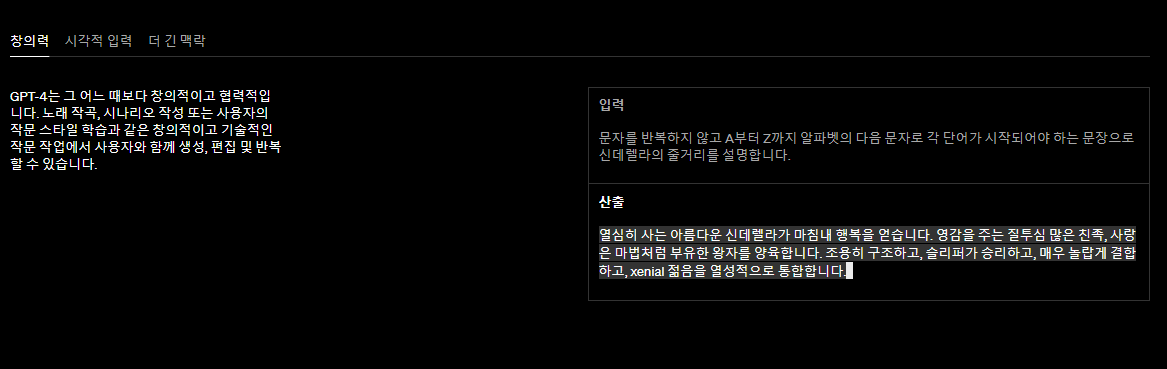

다음과 같이 창의력이 요구되는 작업에서도

뛰어난 모습을 볼 수 있습니다.

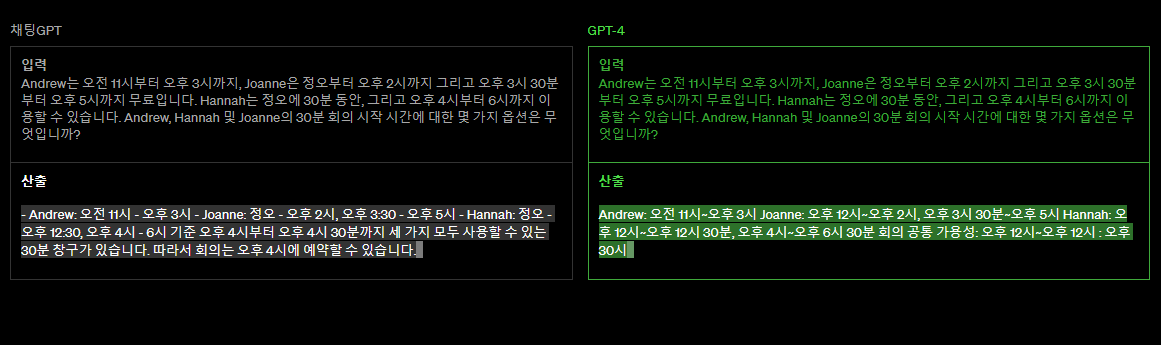

또한, 추론능력이 필요한 부분에서 GPT-3.5보다 더 나은 능력을 보여준다고 합니다.

2. 멀티모달 모델로써의 GPT-4

이 멀티모달 모델이라는 점이 GPT-4의 가장 큰 변화라고 생각됩니다.

기존에도 텍스트를 처리할 수 있는 AI는 많았고,

이미지 생성할 수 있는 AI도 많았지만,

이미지를 통해 사람처럼 소통할 수 있는 AI는 아직까지 없었으니까요.

그럼 멀티모달 모델로써 GPT-4가 어느 정도까지 활용될 수 있는지 보도록 하겠습니다.

공식문서에 나온 예시들을 보여드리도록 하겠습니다.

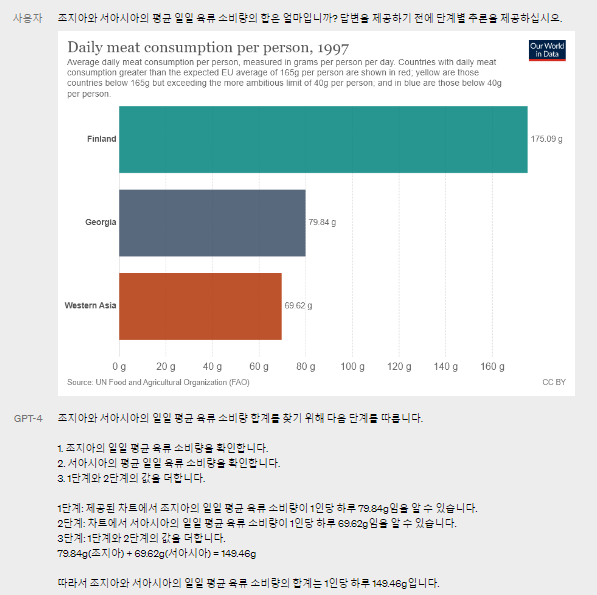

1) 텍스트, 차트, 혹은 그외의 데이터 해석

보시는 것처럼 주어진 이미지를 해석할 수 있습니다.

이미지에 쓰여진 텍스트를 이해하고,

차트의 각각의 값들이 어떤 의미를 가지고 있는지 까지 해석할 수 있는 것을 볼 수 있습니다.

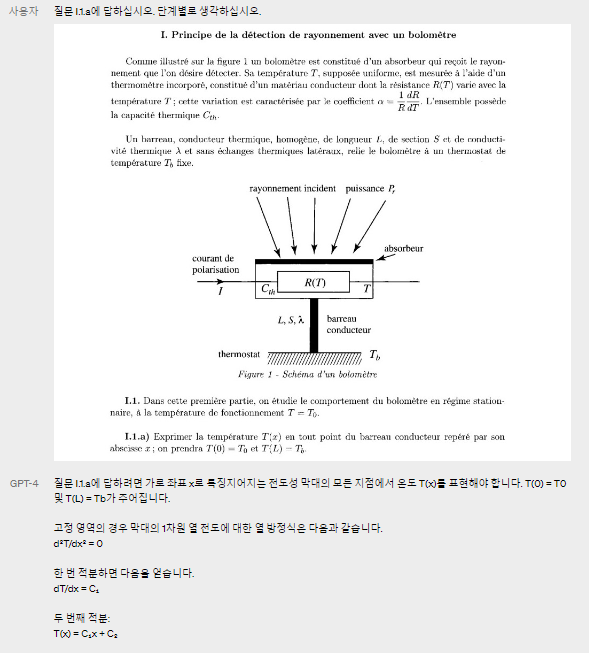

2) 논문 해석

기존의 ChatGPT도 논문을 해석할 수 있었지만 이처럼 이미지를 포함한 논문을 처리할 수 없었다는 한계가 있었습니다.

하지만 GPT-4는 이미지를 포함한 전문성이 필요한 논문들도 해석할 수 있다는 것을 볼 수 있습니다.

기존에 학습되었던 내용을 설명하는 것인지,

아니면 주어진 이미지를 보고 그 자체로만 해석할 수 있는 것인지는 잘 모르겠지만

둘 중 어느것이여도 정말 신기한 기능인 것 같습니다.

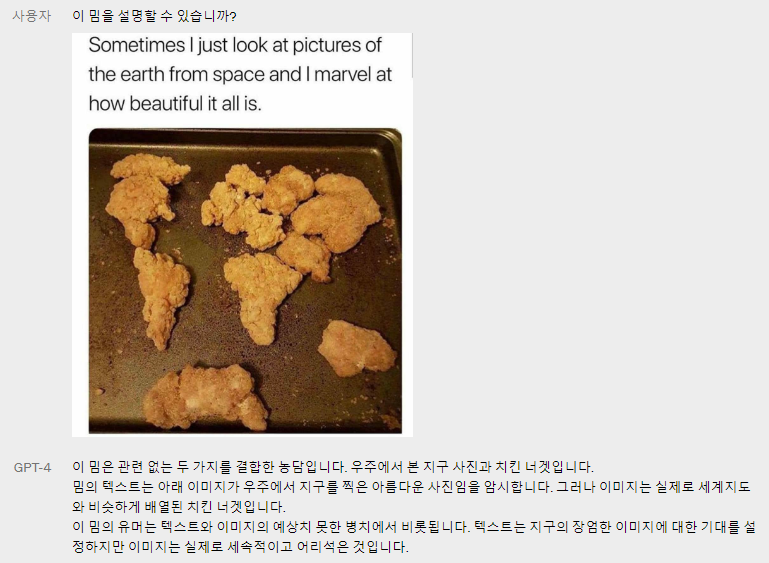

3) 밈/농담

가장 놀라웠었던 기능입니다.

이미지 속에 담긴 유머, 혹은 밈을 이해할 수 있다는 것에서

이미지를 해석하는 과정이 거의 사람과 놀라울 정도로 유사하다는 것을 볼 수 있습니다.

Ⅲ. GPT-4 이용하는 방법

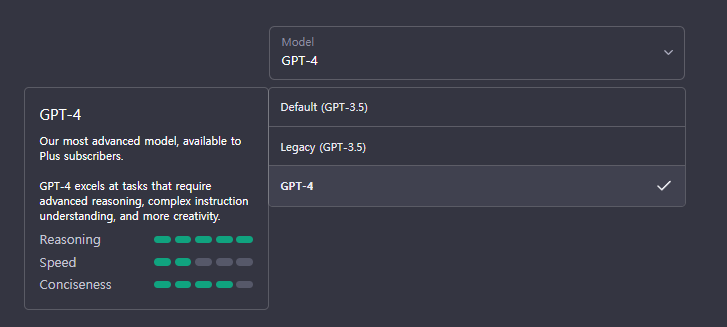

현재 GPT-4는 유료구독인 ChatGPT Plus를 이용하시는 분들만 이용할 수 있습니다.

ChatGPT Plus를 이용하시는 분들은 ChatGPT 사이트에 들어가 보시면

원래 default와 legacy버전만 선택할 수 있었던 곳에 GPT-4가 추가된 것을 볼 수 있습니다.

이렇게 GPT-4를 선택하시면 GPT-4 기반의 ChatGPT와 대화할 수 있습니다.

위의 이미지에서 보시는 것처럼 아직은 속도도 좀 느리고

이미지를 업로드 할 수 있는 기능도 없는 것 같습니다.

아직 출시된지 하루도 되지 않아 조금 불안정한 면이 있겠지만

시간이 지나 안정화가 되고, 속도도 빨라지고, 이미지 업로드 기능도 생기게 된다면

아마 GPT-3.5기반의 ChatGPT보다 활용성이 몇 배는 더 커질 것이라 생각됩니다.

개인적으로는 멀티모달 모델로써의 기능이 주가 될거라 생각했었는데

OpenAI에서는 기존의 텍스트 처리 능력을 개선시킨 것에 중점을 두어 GPT-4를 출시한 것 같습니다.

참고로 보시는 것처럼 4시간에 100개의 메세지 한도가 있다고 하니 참고하시면 좋을 것 같습니다.

추가로 GPT-4의 API가 필요하신 분은 빨리 대기자 명단에 가입하는 것을 추천드립니다.

https://openai.com/waitlist/gpt-4-api

GPT-4 API waitlist

We’re making GPT-4 available as an API for developers to build applications and services.

openai.com

3/14일 자로 출시된 Visual ChatGPT에 대해서도 알고 싶으신 분들은

아래 포스팅을 읽어 보시는 것을 추천드립니다.

Visual ChatGPT 완벽분석 : 생성AI의 특이점이 온다

Visual ChatGPT 완벽분석 : 생성AI의 특이점이 온다

OpenAI에서 새롭게 발표한 Visual ChatGPT, 어떤 기능을 가지고 있으며 어떻게 사용할까요? 안녕하세요 Allan입니다. 이번 포스팅 주제는 3/14일자로 OpenAI에서 깃헙에 배포한 Visual ChatGPT입니다. web상에서

ai-designer-allan.tistory.com